Когда раньше говорили о видео из текста, обычно это означало подписку на дорогой сервис, длинную очередь на рендер и чёткое «нет» от лицензионного соглашения, если речь шла о коммерческом использовании.

Теперь всё меняется: китайская компания Alibaba выпустила Wan2.2 — мощную, бесплатную, открытую модель генерации видео, которая на равных конкурирует с Runway Gen-3, OpenAI Sora и даже Pika Labs.

Что такое Wan2.2

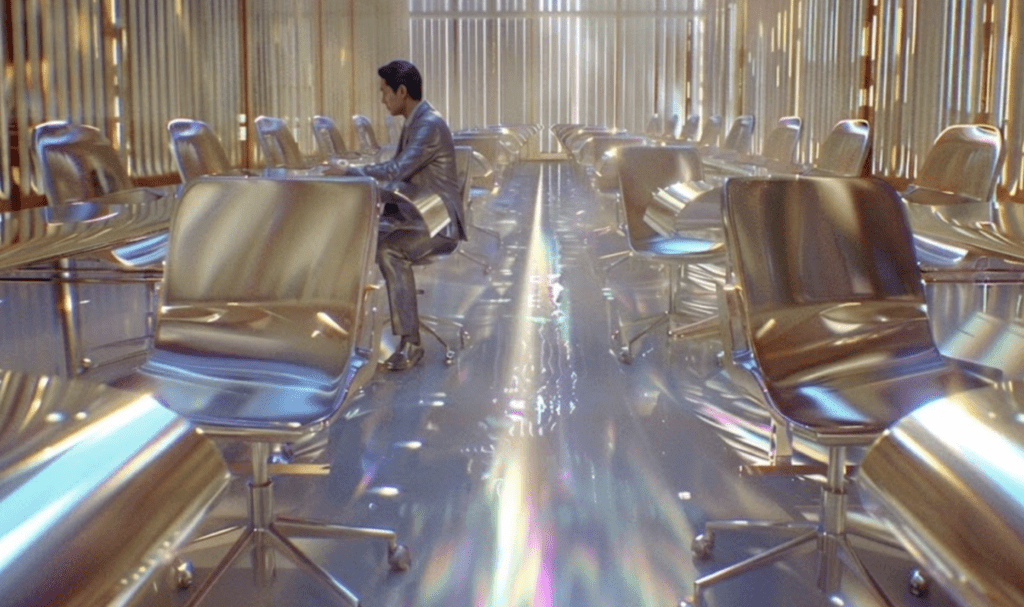

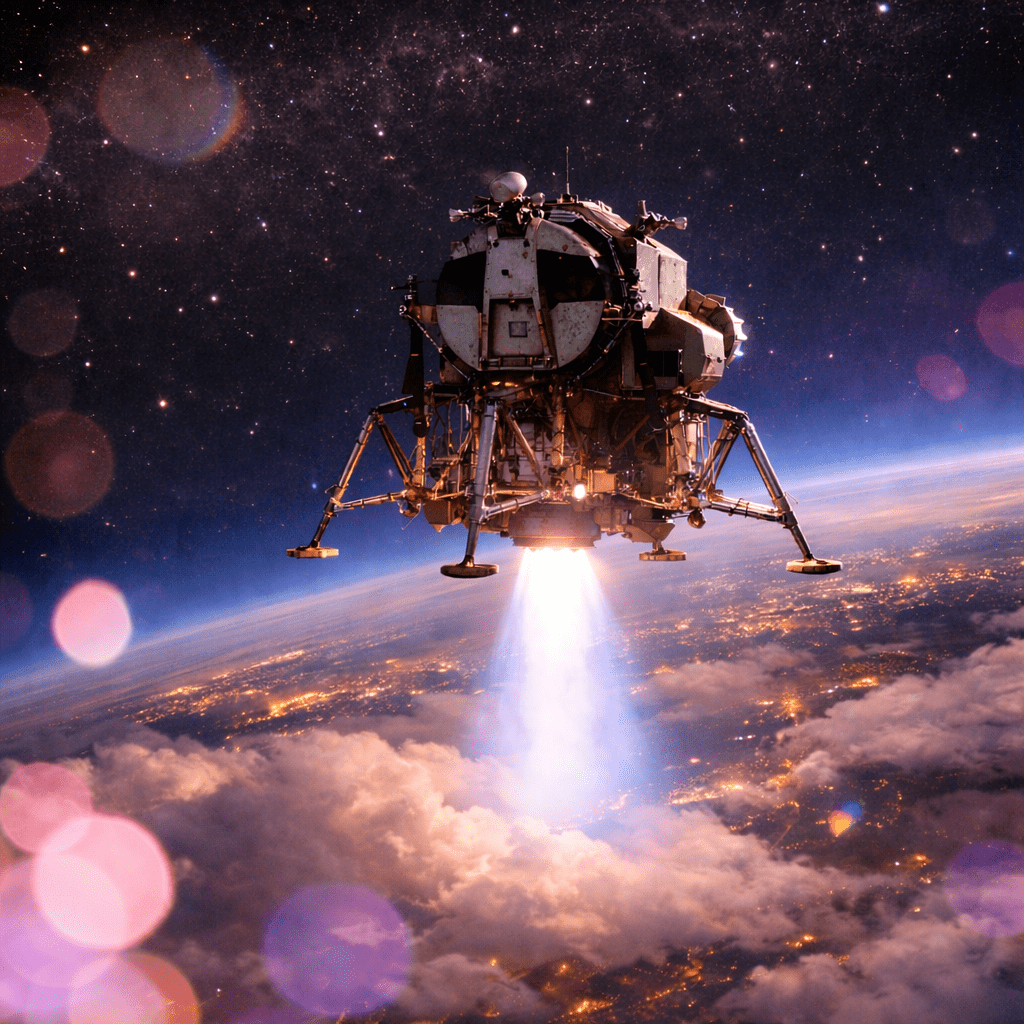

Wan2.2 — это нейросеть, которая превращает текстовые описания в видео. Причём не в простенькие анимации, а в полноформатные видеоролики с детальной картинкой, проработанным освещением и движением объектов.

Она доступна на GitHub и распространяется под лицензией Apache 2.0 — то есть без ограничений на использование, в том числе в коммерческих проектах.

Модель построена на архитектуре Mixture-of-Experts — она включает два отдельных «эксперта», которые поочерёдно работают над сценой: один отвечает за структуру и план кадра, другой — за детали и финишную обработку. Это позволяет достичь фотореализма при относительно низких требованиях к железу.

Главные особенности

Wan2.2 умеет:

- генерировать видео до 1080p и 24 fps

- вставлять текст прямо в кадр (на английском и китайском языках)

- работать даже на потребительской видеокарте (например, RTX 4090)

- принимать и текст, и изображения в качестве входных данных

- выдавать видео, сравнимое по качеству с продуктами Runway и OpenAI

Чем отличается от Runway и Sora

Runway Gen-3 считается лидером в коммерческой генерации видео, но:

- доступ к нему платный (от $15 до $100 в месяц)

- возможности ограничены шаблонами

- нельзя модифицировать поведение модели

Sora от OpenAI пока остаётся закрытой системой, с доступом только по приглашениям.

Wan2.2 от Alibaba предлагает:

- похожее (а местами лучшее) качество

- полную свободу использования

- отсутствие ограничений на коммерческое применение

Три версии модели под разные задачи

1. Wan2.2-TI2V-5B

Для тех, кто хочет попробовать.

Работает на RTX 4090, поддерживает ввод текста и изображений, выдаёт 720p видео за 5 минут.

2. Wan2.2-T2V-A14B

Генерация только по тексту.

Требует минимум 80 ГБ видеопамяти. Выдаёт видео с кинематографическим качеством.

3. Wan2.2-I2V-A14B

Генерация на основе изображения.

Превращает статичные кадры в живую анимацию. Подходит для аниматоров и дизайнеров.

Примеры использования

Что уже создают с помощью Wan2.2:

- Сцену с пятью синхронно танцующими женщинами

- Кота в роли повара с реалистичным паром на кухне

- Аниме-сцены с выразительной мимикой и динамикой камеры

- Гонщика на мотоцикле, вылетающего из огня на закате

Модель справляется с движением, светом, тенями и стилем.

Как писать хорошие промпты для Wan2.2

Качество результата зависит от того, как именно сформулирован запрос.

Основные принципы:

- Используйте английский язык

- Начинайте с основного объекта

- Опишите место действия, свет, движение

- Избегайте противоречий и перегрузки деталей

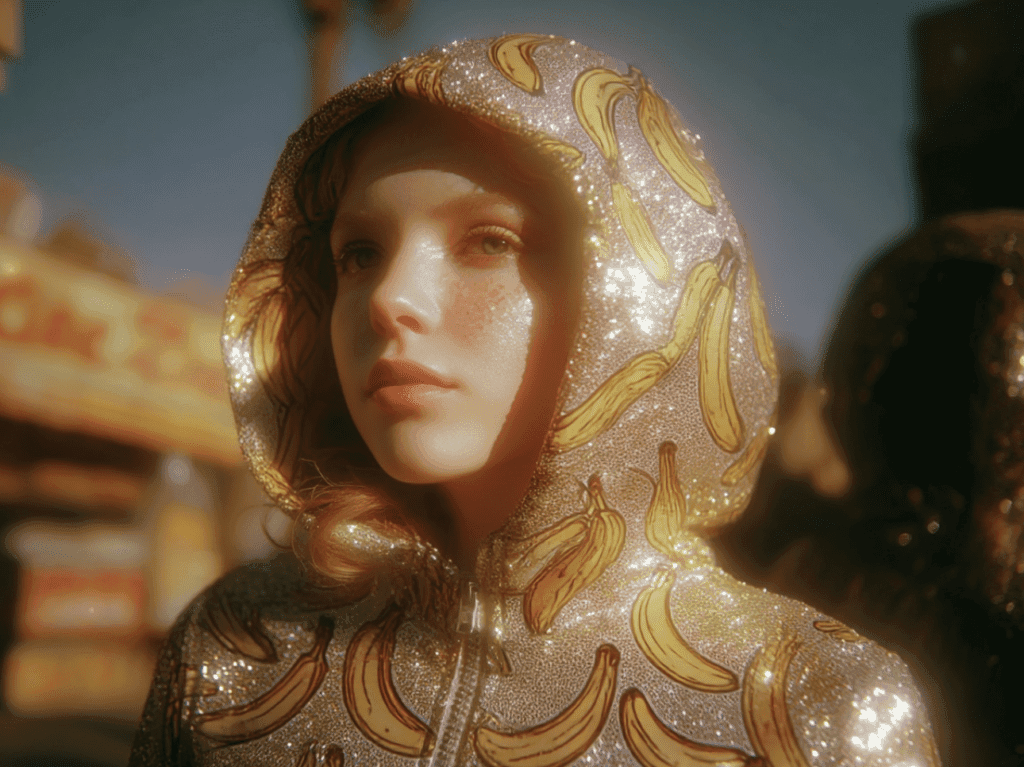

Примеры хороших промптов:

Реализм:

A young woman walks confidently through a futuristic city at night, wearing a silver jacket. Neon lights reflect on the wet pavement. Smooth camera pan. Cinematic lighting.

Аниме:

An anime boy with red hair stands on a rooftop during sunset, wind blowing his scarf, dramatic clouds in the background, stylized lighting.

Экшн:

A cyberpunk motorcycle rider speeds down a burning highway, sparks flying, camera follows from behind, intense orange and blue lighting.

Где уже применяют Wan2.2

- Преподаватели — для визуализации сложных процессов

- Рекламные агентства — для быстрой генерации роликов

- Геймдев — для создания трейлеров и анимаций

- Художники — как инструмент концепт-арта

- Контент-креаторы — для сторителлинга, превью и клипов

Как начать: гайд для новичков

1. Лёгкий способ — через Pinokio AI

- Скачайте Pinokio AI

- Найдите Wan 2.1 (рекомендуется для начала)

- Включите 8-bit модель и VAE Tiling 128×128

- Генерируйте видео через удобный интерфейс

2. Требования к железу

- Для базовой версии:

- RTX 4090 (24 ГБ VRAM)

- 32 ГБ оперативной памяти

- Видео в 720p (5 секунд) — за 4–6 минут

3. Установка через GitHub (для опытных)

- Устанавливается вручную

- Работает через командную строку

- Совместима с ComfyUI и WebUI

- Позволяет кастомизировать пайплайны

Что может пойти не так

- Время генерации: до 9 минут на 5 секунд

- Сложные сцены иногда ломают стабильность

- Высокие требования для профессиональных версий

- Ошибки при установке — если не обновлены драйверы или Python

Что дальше

Скорее всего, скоро появятся:

- Плагины для Premiere и After Effects

- Облегчённые версии модели

- Интеграции с генераторами текста и сценариев

- Онлайн-интерфейсы для генерации без кода

Модель уже сейчас называют аналогом Blender, но для видео — бесплатной, мощной и доступной.

Мини-гайд: как попробовать Wan2.2

Шаг 1. Установите Pinokio AI

Подойдёт для первого знакомства. Установка занимает 5–10 минут.

Шаг 2. Подберите промпт

Пример:

A confident businesswoman stands in a glass office, sunlight streaming through windows, cinematic 4K lighting.

Шаг 3. Проверьте железо

Для 720p достаточно RTX 4090. Для продвинутых моделей — облачный сервер.

Шаг 4. Сгенерируйте видео

Попробуйте короткие сцены. Оценивайте свет, движение и стабильность.

Шаг 5. Экспериментируйте

Подключите ComfyUI, играйтесь со стилями, меняйте длину ролика.