Источник: The New York Times, 8 декабря 2025

Авторы: Steven Lee Myers, Stuart A. Thompson

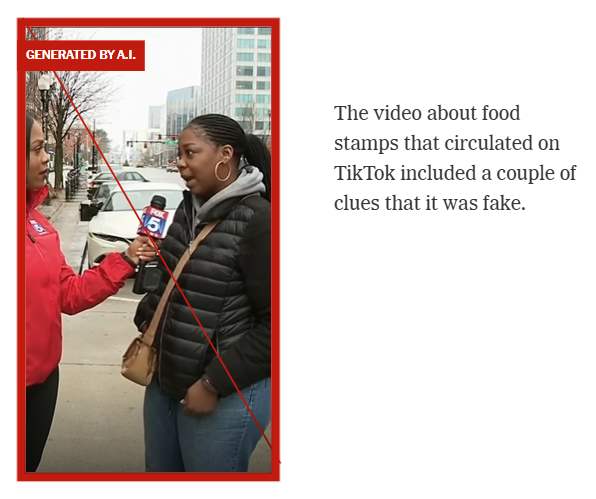

В октябре на TikTok появилось видео, где будто бы женщина даёт интервью телевизионному репортёру о продуктовых талонах — американской госпрограмме помощи малообеспеченным семьям.

Этой женщины не существовало. Интервью тоже.

Видео полностью создано искусственным интеллектом.

Тем не менее большинство зрителей решило, что это реальная запись: будто женщина рассказывает, как продаёт государственные продуктовые субсидии за наличные — что является преступлением.

В комментариях люди реагировали так, словно перед ними настоящая сцена. Несмотря на мелкие признаки фальсификации, сотни пользователей обвиняли женщину в мошенничестве — иногда в расистской форме. Другие нападали на программы социальной поддержки, что совпало с обсуждением планируемых сокращений этих программ администрацией Дональда Трампа.

“Yep fraud! This is what is happening! Cut the food stamps!”

«Да, мошенничество! Вот что происходит! Нужно сокращать программу продуктовой помощи!»

“You’re supposed to use them to feed your children not to sell that you can have cash to pay your rent.”

«Ты должна кормить детей с помощью этой государственной карты, а не продавать её, чтобы собрать наличные на аренду.»

“This system is corrupted. She could go get a job like the rest of us!!”

«Система прогнила. Она могла бы просто пойти работать, как все мы!»

“Americans are overtaxed sheep because of people like her!”

«Американцы переплачивают налоги из-за таких, как она!»

“Admitting fraud!”

«Она прямо признаёт мошенничество!»

“Hopefully she is arrested soon!”

«Надеюсь, её скоро арестуют.»

Как нейросети заполонили соцсети

Такие видео, созданные Sora — новым приложением OpenAI, — показывают, насколько легко теперь можно сформировать альтернативную реальность с помощью простых текстовых подсказок.

За два месяца после выпуска Sora объём вводящего в заблуждение контента резко вырос на TikTok, X, YouTube, Facebook и Instagram. Эксперты фиксируют настоящую волну дезинформации и фейков.

Крупные соцсети формально требуют раскрывать использование искусственного интеллекта и запрещают материалы, созданные с целью обмана. Но эти правила явно не справляются с технологическим скачком, который демонстрируют новые инструменты OpenAI.

Это ещё один A.I.-фейк, который распространяется на Facebook. И «репортёр», и «женщина, которую арестовывают», созданы инструментами искусственного интеллекта, но на видео нет никаких водяных знаков.

Иногда Facebook показывает пометку о том, что видео поддельное — если сам автор укажет это или если платформа добавит уведомление.

В данном случае ролик появился на Facebook без каких-либо отметок, введя в заблуждение сотни комментаторов, которые, судя по реакции, приняли его за настоящее.

Многие A.I.-ролики — безобидные мемы или милые поддельные животные. Но значительная часть направлена на разжигание политических эмоций. Такой контент уже используется в иностранных кампаниях влияния, в том числе — для дискредитации Украины.

«Они явно не справляются с модерацией дезинформации», — говорит Сэм Грегори, директор Witness.

Почему пользователи верят фейкам

Видео о «продаже продуктовых талонов» распространялось в США на фоне длительного правительственного кризиса, из-за которого настоящие получатели помощи SNAP переживали трудности.

Fox News даже использовал другое фейковое видео в статье как «пример злоупотребления». Материал позже удалили.

Фейки используются не только против малообеспеченных людей, но и для высмеивания президента Трампа. Например, видео, будто бы записанное в Белом доме, где голос, похожий на голос Трампа, кричит на кабинет министров из-за документов, связанных с Эпштейном. По данным NewsGuard, видео без какой-либо маркировки набрало более трёх миллионов просмотров.

Почему маркировка не спасает

Соцсети до сих пор в основном рассчитывают, что авторы сами укажут, что контент создан ИИ. На практике это происходит редко.

Хотя платформы могут распознавать A.I.-видео по встроенным метаданным, маркировки:

— появляются поздно,

— плохо заметны,

— иногда отсутствуют вообще.

«Они должны были быть готовы», — говорит Набиха Сайед, глава Mozilla Foundation.

OpenAI и Google добавляют на видео явные водяные знаки и невидимые метаданные. Но многие создатели удаляют водяные знаки, а при пересылке видео метаданные могут теряться.

TikTok заявил, что усилит правила и даст пользователям контроль над количеством «синтетического» контента в ленте.

YouTube использует скрытый водяной знак Sora, чтобы отмечать видео как «изменённое или синтетическое».

Но всё это легко пропустить, когда смотришь ролики на телефоне.

Анализ более 3000 комментариев к тому же ролику показал: почти две трети зрителей восприняли его как реальный.

Нейросети усилили кампании дезинформации

Реалистичные A.I.-видео стали мощным инструментом:

— мошенников,

— политических провокаторов,

— иностранных государств.

Видео, созданные Sora, уже использовались в кампаниях влияния — например, для комментариев коррупционных скандалов в Украине или изображений плачущих солдат на фронте.

Бывшие сотрудники Госдепартамента США Джеймс П. Рубин и Дарьян Вуйица пишут, что развитие ИИ усиливает попытки подрыва демократий.

Они приводят пример A.I.-видео в Индии, где мусульман изображают в унизительном виде, чтобы разжечь религиозную напряжённость. В одном ролике мужчина готовит бирьяни в сточной воде. Хотя на видео сохранился водяной знак Sora, а автор указал, что это ИИ, — ролик распространялся в соцсетях как настоящий.

«Барьер для использования дипфейков исчез, — говорит Вуйица. — А когда дезинформация распространилась, вернуть всё назад почти невозможно.»